No solo los algoritmos de TikTok están causando daños. También los de las otras plataformas sociales que funcionan igual, lo hacen. Pero los algoritmos del sistema de recomendación de YouTube, y el de la red social TikTok son los más adictivos de todo el internet social.

El Juez Paul Matey, del tribunal federal del tercer circuito (tribunal intermedio en EE.UU. entre los tribunales federales y el Supremo), ha tomado una decisión histórica contradiciendo con su sentencia al tribunal anterior de primera instancia, declarando responsables a la empresa TikTok Inc. y a su matriz china ByteDance, empresas dueñas de la plataforma TikTok, de la muerte de Nylah Anderson una niña de diez años que participó en la red social en el «reto del apagón», un horroroso e irracional reto, que le acabó costando la vida a la niña. Luego veremos detalles.

La información citada me llegó por Matt Stoller director de Investigación del American Economic Liberties Project y autor del libro Goliat que trata de la guerra de los 100 años entre el poder monopolístico y la democracia. Fue Matt quien me señaló primero la importancia histórica de esta sentencia y del juez que ha dictaminado que TikTok debe ser juzgada por manipular a niños para que se hagan daño, saltándose los anteriores criterios de aplicación de la ley durante años conocida como la Sección 230 de la Ley de Decencia en las Comunicaciones de EE.UU. Ley que concedió de facto una larga impunidad a las empresas de plataformas de redes sociales sobre los daños que causen, siempre y cuando pudieran decir que «el algoritmo fue quien lo hizo». Una sentencia valiente la de este juez, que hace retroceder la ley 230 y pone fin al escudo sobre la responsabilidad que las grandes empresas tecnológicas utilizan para cometer malas acciones sin consecuencias y con casi total impunidad.

Las reacciones no se han hecho esperar. Por ejemplo, la profesora y jurista Zephyr Teachout de la Escuela de Leyes de la Fordham University de Nueva York, ha manifestado que «La sentencia es una decisión realmente sustancial e importante, que por fin interpreta la Directiva 230 tal y como estaba concebida, y no amplía la inmunidad a los contenidos promovidos algorítmicamente». En el mismo sentido su colega Mike Sacks señala que «el tribunal CA3 afirma en la sentencia que la Sec. 230 no protege a TikTok y ByteDance por crear un algoritmo que alimentó el ‘desafío blackout ‑apagón-’ y tuvo como víctima directa a una niña de 10 años que intentó seguir este irracional reto hasta las últimas consecuencias y se ahorcó accidentalmente».

La Sección 230 de la Ley de Decencia en las Comunicaciones ha sido un puntal en los modelos de negocio de las actuales grandes tecnológicas y plataformas de redes sociales, dotándoles de impunidad legal desde hace mucho tiempo, a pesar de que ya es un clamor el enorme daño en salud mental que causan sus plataformas. y que ha hecho que el mismísimo Ayuntamiento de Nueva York haya declarado que las redes sociales son un «peligro para la salud pública» y una toxina medioambiental».

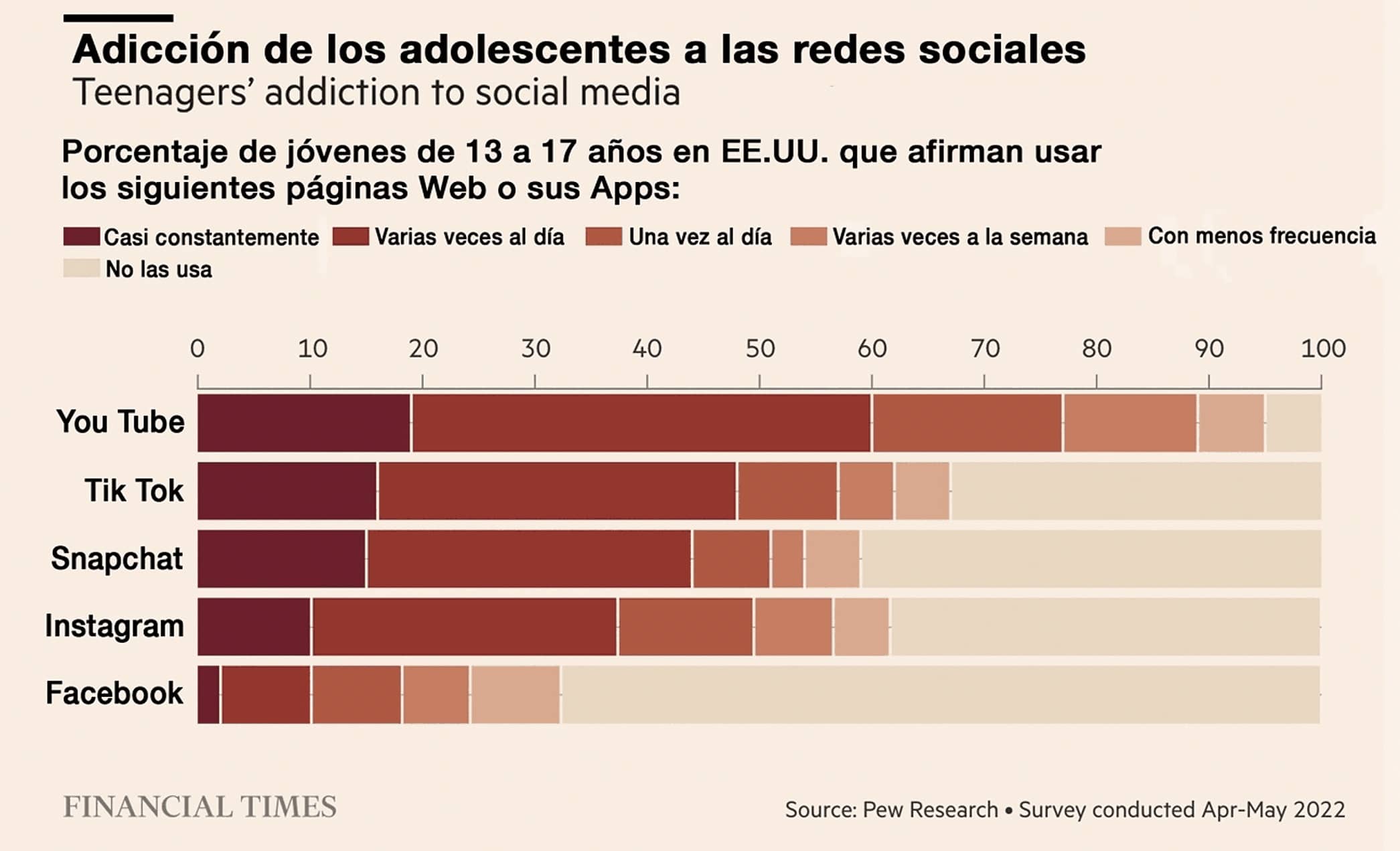

No solo los algoritmos de TikTok están causando daños. También los de las otras plataformas sociales que funcionan igual, lo hacen. Una investigación de 2022 de Financial Times lo señalaba en detalle. Los gráficos a continuación, hablan por sí mismos.

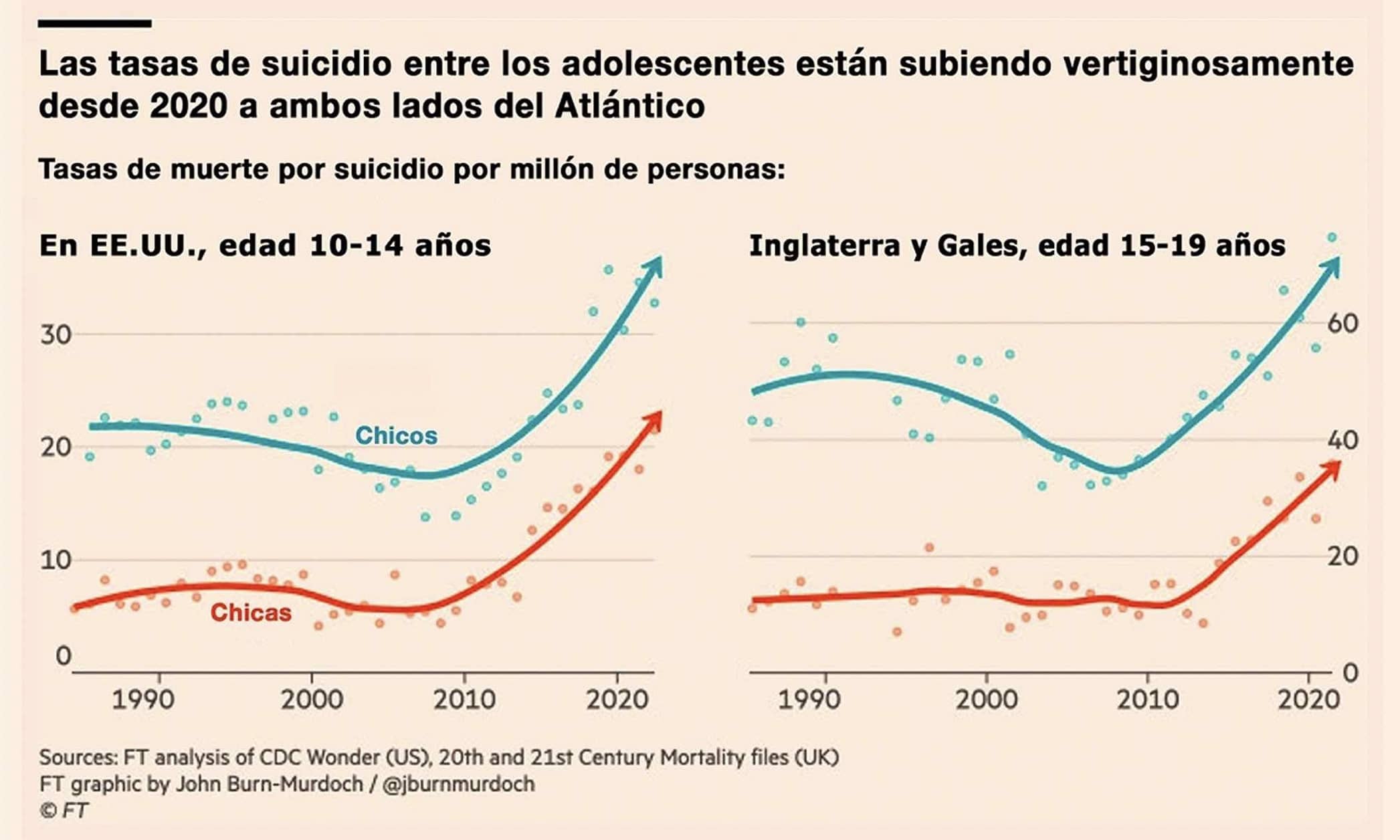

Y los daños no solo son de adicción, sino también de diversos tipos de problemas de salud mental que, en el caso de algunas edades adolescentes, se ha convertido en un auténtico problema social. En el mismo informe de FT se puede ver el gráfico de la evolución estadística de suicidios infantiles y adolescentes tanto en chicos como en chicas en los últimos 30 años en EE.UU. y Reino Unido, tienen un punto de inflexión al alza, justo el año 2008, –año del nacimiento a la popularidad de este tipo de plataformas de red social y de la explosión de Facebook–. En este año, cambió la tendencia y se aceleró en el número de casos:

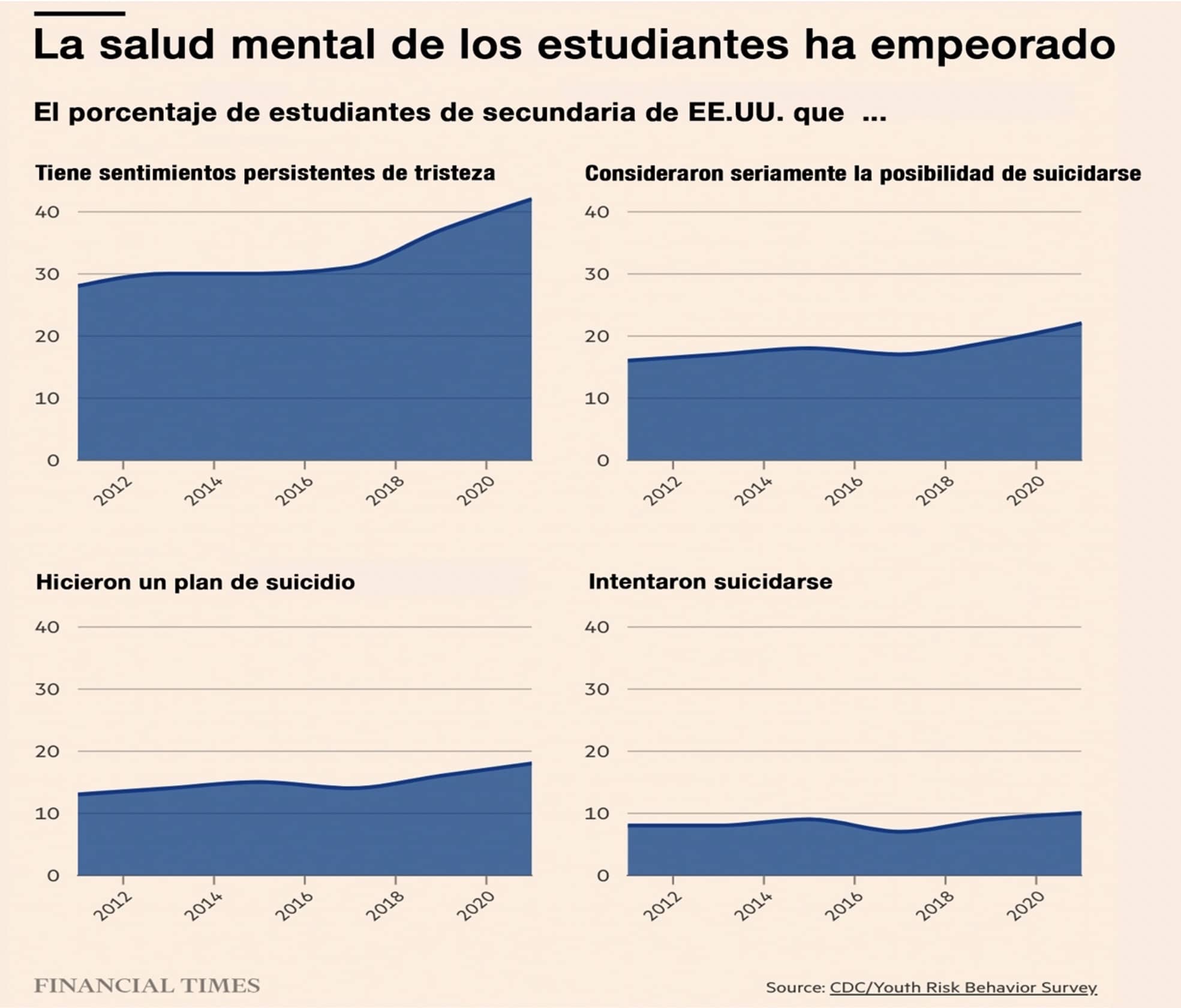

Normalmente estas disputas legales acaban, –y se acallan–, mediante un acuerdo económico de indemnización. Pero, yo creo que este problema, ya va mucho más allá de indemnizaciones concretas y dinero. Es ya un problema humano y social en crecimiento. Y ya se ha demostrado que las demandas no han servido para que estas enormes empresas tecnológicas cambien su conducta sobre el control y las prácticas de sus usuarios. Y las multas que se les imponen son como pinchar a un elefante como un alfiler. En el mismo informe aparece otro muy preocupante gráfico (ver a continuación) que da una idea de dicho crecimiento y de que en salud mental en los jóvenes vamos casi hacia una epidemia social. Y los usos de la tecnología digital que imponen las plataformas sociales tienen que ver con ello.

Muchos padres y legisladores culpan, y con razón, a las empresas de redes sociales que, según ellos, desarrollan productos altamente adictivos que exponen a los jóvenes a material nocivo con, a veces, fatales consecuencias en sus vidas en el mundo real. Resulta irónico que las plataformas se defiendan alegando que su tecnología permite a las personas establecer relaciones beneficiosas para la salud mental. Lo cual, no siempre es cierto. A veces sucede lo contrario.

Jonathan Haidt, psicólogo social y profesor de la Escuela de Negocios Stern de la Universidad de Nueva York declaró a FT que «Cuando aparecieron las redes sociales o Internet de alta velocidad, distintas investigaciones se encontraron, casi todas, con la misma historia. La de que la salud mental está cayendo en picado, especialmente en el caso de las chicas». Sin embargo, algunos académicos señalan que cada vez hay más estudios que son difíciles de ignorar. La proliferación de teléfonos inteligentes combinados con Internet de alta velocidad y aplicaciones de redes sociales, están reconfigurando el cerebro de los niños y provocando un aumento de los trastornos alimentarios, depresión y ansiedad. El informe de FT señalaba casos personales con la colaboración y permiso de las familias para concienciar a la sociedad.

Dos casos de suicidio adolescente documentados en el Informe de Financial Times.

Le empresa Meta, dueña de Facebook e Instagram, insiste en que sus plataformas también eliminan contenidos relacionados con el suicidio, las autolesiones y los trastornos alimentarios. Estas políticas se aplicaron con más vigor tras la muerte de la colegiala británica de 14 años Molly Russell, que se quitó la vida en 2017 después de ver miles de publicaciones sobre el suicidio. Los casos similares aumentan.

En octubre de 2023, 41 de estados fe EE.UU. demandaron a Meta, empresa matriz de Instagram, por supuestas funciones adictivas y daños a la salud mental de los jóvenes. Se han presentado demandas legales en 41 estados, incluida una conjunta de 33 fiscales generales, en las que se acusa al propietario de Instagram y Facebook de «sacar provecho económico del dolor de los niños». En cierto modo es un nuevo sistema digital de explotación infantil. Las demandas deberían ser un paso adelante en exigir responsabilidades a las, hasta ahora, intocables plataformas de redes sociales gracias a la Ley 230. Pero los hechos indican que la sociedad y sus autoridades no reaccionan, insisto, porque no hay ninguna sensación de peligro en la gente ante unos instrumentos y usos tecnológicos que activan a todos constantemente, sin descanso y personalizadamente, el circuito cerebral de recompensa.

La perspectiva sobre todo ello te cambia, doy fe, cuando conoces un caso cercano y personal, o cuando te cuentan cómo es el recibir en tu día a día en el hospital, tan frecuentemente, y cada vez más, casos de familias con un niño o niña que se acaba de intentar suicidar, como le ocurre a Francisco Villar, psicólogo infantil y juvenil, experto en psicología clínica y conducta suicida en la adolescencia, y autor del libro Cómo las pantallas devoran a nuestro hijos, que presentamos juntos. Lo normal es que nos digan que estamos exagerando, pero créame el lector. No exageramos en absoluto. Pero resulta difícil decirle a toda esa gente que sonríe a su móvil por la calle presos de una actitud nihilista, usando una App que puede ser mortífera, no para todo el mundo, pero sí para personas vulnerables, ya que no tienen el menor nivel de alerta sobre ello.

Para entender cómo es posible que Nylah Anderson una niña de diez años que se metiera de forma extrema en el oscuro pozo, del «Reto del apagón» (así se llama), que acabó con la vida de esta la niña, hemos devolver al caso de TikTok y ver en detalle, cómo actúan sus algoritmos en casos como este y otros. La muerte prematura de Nylah y otras como la de ella, todas evitables, ya justifican, por sí solas esta diatriba que estás leyendo, lector.

TikTok, no es lo mismo dentro que fuera de China

Como explica Mónica Torres en la revista del Instituto Politécnico de Monterrey, los algoritmos de TikTok, son los más adictivos de los conocidos hasta la fecha. Lo hacen globalmente, y además guiados por datos que le proporciona inocentemente el propio usuario/a, que en muchos casos acaba, por sí mismo, dentro de una sofisticada trampa de adicción, hoy por hoy casi infalible, y que, además, lleva siempre consigo. Sin importar tu ciudad o lugar de residencia, a qué te dediques, o cómo sea tu tiempo de ocio o trabajo, TikTok es una red social que promete enganchar a sus usuarios en solo unas horas, enviando, para que no te distraigas en otra cosa, de manera individualizada, constantes notificaciones sonoras y gráficas que se superponen constantemente a cualquier cosa que esté en ese momento en la pantalla. Esas continuas interrupciones destruyen, por ejemplo, los procesos de aprendizaje en las aulas, si no se les pone coto de alguna manera.

Algo que parece ser el objetivo del algoritmo de dicha App en el móvil, ‑mediante un complejo sistema diseñado para enviar a sus usuarios todo tipo de contenidos–, son aquellos que más los harán reaccionar emocionalmente, señalados en los picos de su estadística predictiva emocional registrada constantemente por el móvil en el algoritmo personalizado de la App de TikTok. También ocurre en las demás.

Hay que hacer la salvedad de que esto ocurre en el TikTok internacional de la empresa china TikTok inc. que tiene su sede fiscal en las Islas Salomón, un paraíso fiscal. Pero no, –y esto es importante–, en Douyin, la versión de TikTok de la misma empresa, que solo está disponible para usuarios del interior de China y que usa un algoritmo diferente, aunque ambas pertenecen al gigante empresarial ByteDance, con sede en China y en cuyo consejo se sienta un miembro del Comité Central del Partido Comunista de China. La empresa Bytedance funciona bajo la supervisión y regulación del Gobierno de China, al que entrega datos de adolescentes de todo el mundo ante cualquier petición de su gobierno «si fuera necesario”. Aunque TikTok y Douyin comparten estética, ofrecen contenidos con métodos distintos. La versión para el interior de China de esta red social sí tiene salvaguardias y limitadores de tiempo para evitar el exceso de uso sobre todo en los niños. Hasta las autoridades chinas conocen el daño que un mal uso de las plataformas pueden hacer. De ahí que impongan severas restricciones. Cualquier padre cuyos hijos infrinjan estas limitaciones puede acabar en la cárcel ipso facto por ello.

Por lo visto, a los gestores del TikTok internacional, –el que conocemos por ejemplo en España–, en cambio los niños y adolescentes occidentales no les parecen dignos de protección. Al contario, para el uso por niños y niñas chinos imponen todo tipo de salvaguardias y restricciones. Por ejemplo: para evitar la sobreexposición, Douyin establece por defecto un tiempo máximo de 40 minutos en la App para los usuarios chinos menores de 14 años. También para el interior de China, el tiempo de uso para adolescentes entre los 15 y los 17 años se reduce a una hora. Ya los niños, niñas y adolescentes en China se les impide y no pueden usar Douyin de 22:00 a 06:00 horas. Además, las temáticas de Douyin están muy limitadas y deben cumplir con las políticas emanadas del Partido Comunista Chino. Lo cual no digo que sea tranquilizador. Además. en esta red en China se promueven, como era obvio, contenidos que impulsan valores nacionales y mensajes oficiales del estado. ¿Importa todo esto a los usuarios del mundo y de España, y a los periodistas que hablan y usan TikTok? Parece que no, en absoluto. Es una moda digital y eso parece ser lo único importante para los nihilistas social media victims.

La afilada herramienta del scroll infinito de TikTok

Hay otro detalle. El algoritmo de TikTok es altamente personalizable y alimenta el feed (una banda vertical de contenido continuo y sin fin) que aparece la interfaz de la App Tiktok en pantalla del móvil al elegir For You Page (para tu página). Técnicamente esto se llama scroll infinito y fue creado para ofrecer a los usuarios un flujo interminable de contenido, priorizado a partir de lo que se ha registrado mediante la Aptigraphy y la Typpography ‑como ya expliqué en estas páginas– por los sensores de su Smartphone. Nada que aparece en la pantalla de al App es casual ni aleatorio como suele creer el usuario. El objetivo es asociar lo que aparece en pantalla coincidiendo con picos de emoción en la estadística de uso de ese usuario en particular. Y ese tipo de contenido es el que prioriza el algoritmo para enviarlo constantemente, con el fin de que no tengas tiempo de tomar ninguna decisión, ni haya tiempos muertos e interactúes al instante, compulsivamente, sin pensar. Esto hace que la aplicación sea no solamente entretenida, sino que sea particularmente adictiva. Es una sofisticada herramienta ante la que los usuarios están indefensos, que les bombardea sin tiempo para decidir, desde que, enganchados, le siguen el juego al algoritmo.

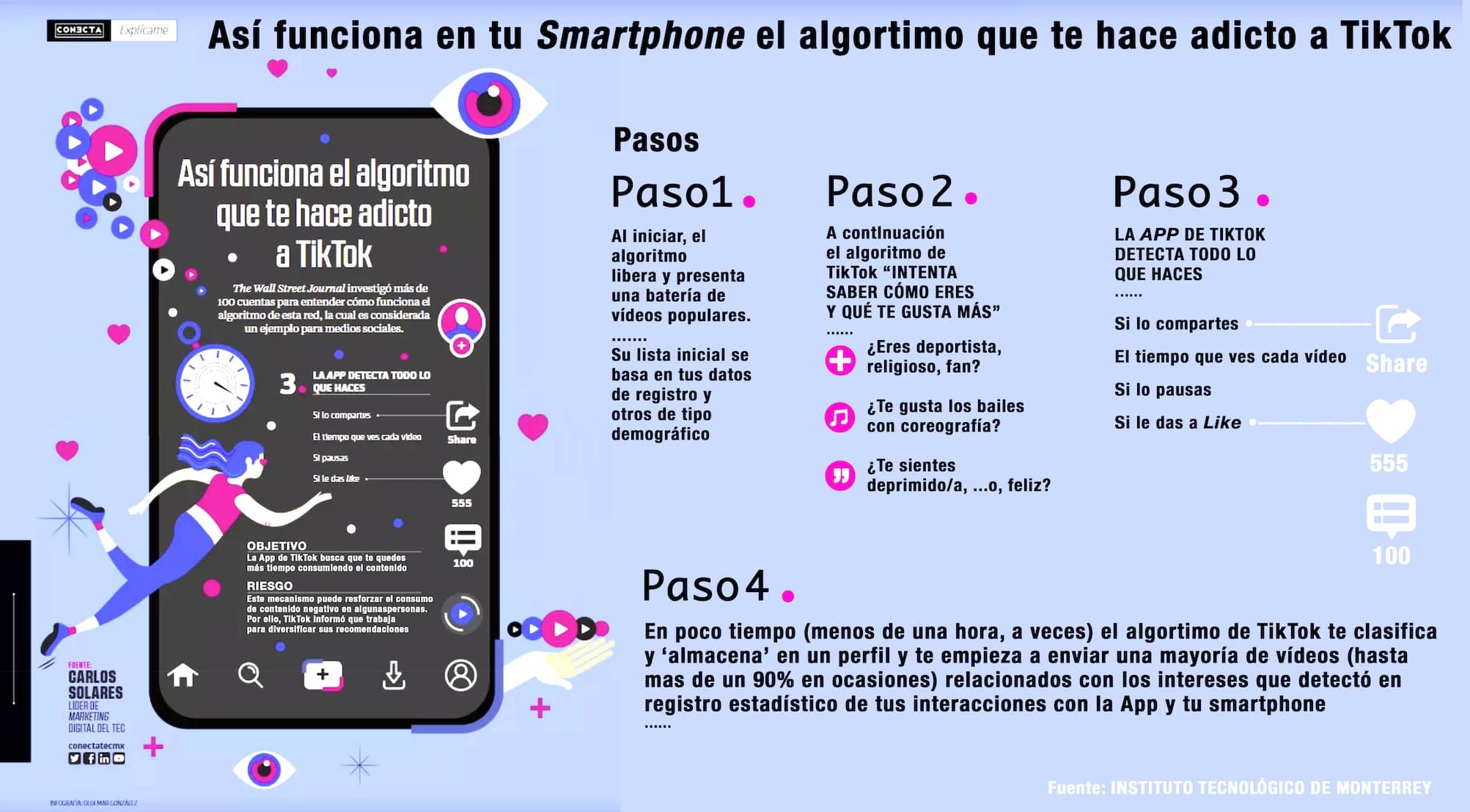

Carlos Solares, responsable de Marketing Digital del Tech. Institute de Monterrey señala «El algoritmo de TikTok es mucho más agresivo que el de otras plataformas. Ves un vídeo y luego, de inmediato, ya caes en una categoría». Por su parte, David Guerra, responsable nacional de Salud Emocional de la Universidad Tech. Milenio explica: «Nos encierran en una burbuja y sólo nos muestran lo que supuestamente ‘queremos ver’, esto sesga nuestras opiniones desde un inicio y nos aísla del mundo real». Algo especialmente grave en las personas de corta edad ya que sus efectos sobre las mentes infantiles son tremendos, como la ha pasado a la niña citada Nylah Anderson que con diez años ya estaba en TikTok de forma ilegal. Pero la red social, igual que sus colegas, no hace cumplir sus propias normas, ni se molesta en comprobar la edad de los usuarios. Me reitero, va en dirección contraria a lo que persigue su modelo de negocio.

Además, dicho algoritmo busca que no haya dos usuarios que vean exactamente los mismos vídeos en su página central debido a que cuenta con una función de aprendizaje iterativo. Gracias a ella, los vídeos que ves pueden cambiar con el tiempo en función de tus preferencias de visualización e incluso apelando al supuesto estado de ánimo en el momento que te lo está midiendo los sensores de su Smarphone. Según Guerra «Este tipo de algoritmos pueden ser muy agresivos según el uso que les demos, y el usuario debería ser muy consciente de los datos con que él mismo lo alimenta», cosa casi imposible en el uso compulsivo típico que suelen hacer los adolescentes y sin el tiempo para pensar por si mismos, ya que les ha sido robado por inundación de información.

Cómo funciona el algoritmo de TikTok y por qué es tan adictivo

El prestigioso The Wall Street Journal (WSJ) investigó ya en 2021 más de 100 cuentas para entender cómo funciona el algoritmo de esta red, que ya se está considerando como un ejemplo puntero cuyas capacidades de engaggement (enganche) son un ejemplo para las distintas Apps con las que interactúan sobre todo los adolescentes.

En términos inteligibles para los no iniciados, el algoritmo de TikTok es un poderoso sistema de recomendación que determina los vídeos que aparecerán en la página principal o For You Page del usuario, en cuanto este abre la App de TikTok en su móvil.

La plataforma genera un nivel de adicción y de dopamina que ni Facebook, ni Twitter ni Instagram ni WhatsApp consiguieron en su momento. Para llegar a su punto álgido, inicialmente el algoritmo libera una batería de vídeos populares basándose en los datos de registro, y su tipo demográfico. Al ir aumentando la interacción y las emociones, cuyos picos mide la estadística predictiva de la Apptigrafía y Tappigrafía en la pantalla táctil, del Smarphone, esto se traduce en que la plataforma a partir de los shares (contenidos compartidos, re-enviados, etc.); datos sobre el tiempo en que se ve cada vídeo; qué patrones de pausas y pulsaciones se hacen sobre la pantalla (tippography) y los likes (me gusta), el algoritmo hará una configuración para poner en pantalla aquello que haga reaccionar más intensamente al usuario. El algoritmo se adapta como un guante personalizado a la respuesta emocional del usuario. Esto es tremendo porque no deja de actuar nunca. Estos algoritmos no duermen ni descansan. La adicción está servida.

En muy poco tiempo, incluso en menos de una hora en ciertos casos, la App habrá creado y clasificado un perfil personal y según él y, retroalimentado sin que él lo sepa, por las propias acciones del usuario. Irá enviando sucesivamente y/o recomendando una enorme cantidad de determinados vídeos (hasta el 90% en ocasiones) relacionados y asociados a los intereses que detectó en el propio usuario. No olvidemos que estamos hablando (aunque no solo) de una gran cantidad de usuarios niños y/o adolescentes.

Todo ello tiene objetivo de facilitar el engagement de los usuarios con la App, consumiendo el contenido que fue seleccionado «sólo para ti» y haciendo más probable que caigas en un hoyo de información o rabbit hole (es una referencia a la guarida del conejo de Alicia en el País de las Maravillas), que es lo que le pasó a la niña Nylah Anderson con 10 años, quien se acabó auto-estrangulando a sí misma.

«La consecuencia es que el usuario llega a un punto en el que el algoritmo sólo le muestra contenido de personas que están opinando exactamente lo mismo que él, algo que es bastante peligroso para la seguridad de niños y adolescentes que aún están solo empezando a desarrollando criterios racionales propios», opina David Guerra.

Esto implica riesgos muy serios. Los inducen estos algoritmos de TikTok porque la conducta de los jóvenes es re-conducida drásticamente sin que ellos sean conscientes de que dejan de pensar y tomar gran parte de las decisiones sobre su propia conducta en el proceso. Su tiempo para reflexionar o decidir por sí mismos les ha sido, sutilmente, robado. Y además todo ello puede reforzar el consumo hacia lo negativo en muchas personas. La empresa ha informado, (solo ponen paños calientes), que se encuentra trabajando por mejorar esto, pero yo creo que va a ser algo difícil que lo hagan, ya que su algoritmo no discrimina o filtra los tipos de contenido. Y otra consecuencia muy negativa es que, dado que los jóvenes todavía se encuentran en un grado de desarrollo cerebral incipiente, su centro de gratificación cerebral se puede acostumbrar a estar constantemente sobreestimulado. Y, por tanto, la adicción emocional está solo a un paso. Como señala el especialista Solano, del Monterrey Tech, además, aparece una paradoja: «las variables estimulantes de consumo que establece TikTok son aparentemente de bajo involucramiento, pero ello ayuda a que el sistema de gratificación del usuario, –hablamos de cerebros de adolescentes, sobre todo, con escaso autocontrol– se alimente vía digital, constantemente, con una sobrecarga de endorfinas y dopamina de un nivel nunca visto antes».

Por todo ello, y el contexto (la conexión siempre se hace en solitario), resulta que los tiempos muertos sin usar la plataforma TikTok generan un estado emocional similar a un síndrome de abstinencia. Por su parte, Guerra, advierte que, en esa situación, existen altas posibilidades de que se generen conductas auto-dañinas como trastornos alimenticios o pensamientos suicidas que serán reforzados, al punto de generar una adicción a los mismos. Lo cual es aberrante y muy peligroso. Pero las estadísticas que señalan los gráficos de arriba no dejan lugar a dudas de que esto sucede a muchos jóvenes.

«El mayor riesgo es que el algoritmo afecta nuestro circuito cerebral de gratificación y empezamos a sustituir con él otras actividades de nuestra vida diaria, porque nuestro cerebro recibe incansablemente más y más estímulos de la App, sin tener que realizar apenas esfuerzo», aclara. Pero hay más. Independientemente de la edad, el algoritmo puede lograr que cualquiera de sus usuarios incremente de manera exponencial su tiempo en la App TikTok, cuando cae en un rabbit hole de información, sobre todo cuando se trata de uno negativo. Esto se sabe. Los dueños de las plataformas saben el dolor que están causando a muchas personas. Incluso lo que los usuarios deberían hacer. Lo señalan hasta las normas para el Douyin del interior de China: limitar drásticamente el tiempo en que se está en la App. O sea, simplemente desconectarse. Pero eso va radicalmente contra sus modelos de negocio y de lo que sus algoritmos promueven incansablemente. Ir a contracorriente en eso, es muy muy difícil en el mundo actual infectado de modas digitales viralizadas.

Dicho lo anterior, esto no afecta solo a los adolescentes. Todos estamos involucrados; todos usamos Smartphone, pero la vulnerabilidad es distinta en cada uno. Cuando digo en el súper que no quiero la App me miran raro. En España, muchos medios abren secciones con cosas de TikTok pensando que todo el mundo esta ahí y que también están ahí muchas claves de lo que pasa. Pensando que refiriéndose a ello ganarán audiencia, o parecerán informados. Es una ilusión. El funcionamiento del nuevo algoritmo que ha impuesto Elon Musk en X desmiente eso. Cuanto más te informes y permanezcas en las redes sociales más desinformado estarás. Ahora mismo, X no es en absoluto como Twitter; se ha convertido en un motor de información falsa y extrema mediante una decisión consciente, simplemente porque hoy sus algoritmos modificados promueven, difunden y aceleran exponencialmente la información mentirosa ya que es mucho más negocio que la verdadera, y produce mucho más engagement. En realidad, es muy simple: solo buscan maximizar el tiempo de permanencia en cada conexión a X, y el número de accesos a X por unidad de tiempo en cada usuario. Siempre. Y los algoritmos no hacen ni saben hacer excepciones. Pero modas, popularidad y lo viral, mandan ahora. Incluso numerosos profesionales de los medios son hoy verdaderas víctimas propiciatorias de su propia dependencia de algoritmos y sistemas de recomendación, similares a los de TikTok.

Volviendo al tema central, me pregunto si los legisladores, como están empezando a hacer los de EE.UU. y Europa, o jueces valientes como ha hecho Paul Matey serán los que comiencen a abrir un camino que creo, salvará muchas vidas jóvenes y adolescentes. ¿Cuantas muertes han de ocurrir como la de Nylah Anderson de 10 años, Ian Ezquerra de 16 o Molly Russell de 14, que ya no están entre nosotros, para que la sociedad al completo tome conciencia?

Lo peor es que estoy convencido de que incluso estas muertes adolescentes que he citado como ejemplo, entre muchas más, se podrían haber evitado. Este lado oscuro de unas sofisticadas sociedades globales siempre con alegría aparente, fans enloquecidos y consumidores compulsivos sin fin presos de las modas digitales, por mucho que se le ignore, sigue ahí. No soy nada ludita y me gustaría haber hablado hoy de forma más optimista sobre estas tecnologías y sus mejores usos. Las he usado durante años con mis alumnos en mi etapa del MIT, casi ocho años antes de que naciera Facebook, sin likes, ni algoritmos perversos, ni Sourveillance, y son una maravilla. Estas de TikTok, FB, Instagram, WhatsApp, o las de Meta, no tienen en su uso nada que ver con aquello. Pero creo que lo que he contado hoy debe saberse. Espero que con la citada sentencia valiente por encima de la ley 230 y de sus impunidades legales, se abra un nuevo camino de mejora hacia una etapa más esperanzadora. Falta nos hace.

Comparte esta publicación

Suscríbete a nuestro boletín

Recibe toda la actualidad en cultura y ocio, de la ciudad de Valencia